Decodeunicode – das Buch der Zeichen ist da

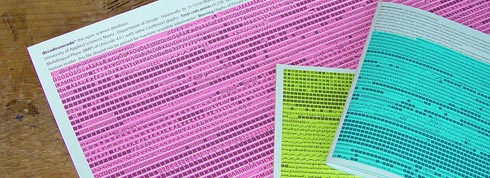

Dieses Buch ist der Hammer … am Freitag vergangener Woche auf meinem Schreibtisch gelandet, musste ich am Wochenende immer wieder darin blättern, weil es mich magisch anzog. In einem Buch »blättern« bedeutet üblicherweise, seinen Inhalt mehr oder weniger (un)interessiert zu überfliegen. Bei Decodeunicode ist das Blättern Teil des Systems, denn es ist erstens ein Nachschlagewerk und zweitens macht es das Universum Unicode physisch zugänglich. Immerhin sind auf 656 Seiten alle Schriftzeichen der Welt untergebracht, etwas genauer sind das 109.242 Zeichen.

Unicode ist ein internationaler Standard, in dem langfristig für jedes sinntragende Schriftzeichen oder Textelement aller bekannten Schriftkulturen und Zeichensysteme ein digitaler Code festgelegt wird. Das Ziel des Unicode Konsortiums ist, die Verwendung unterschiedlicher und inkompatibler Kodierungen in verschiedenen Ländern oder Kulturkreisen zu beseitigen – also den Bauplan für den Turm zu Babel nachzuliefern. Unicode wird ständig um Zeichen weiterer Schriftsysteme ergänzt. 1991 wurde nach mehrjähriger Entwicklungszeit die Version 1.0.0 des Unicode-Standards veröffentlicht, die damals nur die europäischen, nahöstlichen und indischen Schriften kodierte, alles in allem ein paar hundert Zeichen. Die neueste Version ist 6.0.0, veröffentlicht im Oktober 2010 und Basis für die über 100.000 in diesem Buch vorgestellten Zeichen.

Unicode ist ein internationaler Standard, in dem langfristig für jedes sinntragende Schriftzeichen oder Textelement aller bekannten Schriftkulturen und Zeichensysteme ein digitaler Code festgelegt wird. Das Ziel des Unicode Konsortiums ist, die Verwendung unterschiedlicher und inkompatibler Kodierungen in verschiedenen Ländern oder Kulturkreisen zu beseitigen – also den Bauplan für den Turm zu Babel nachzuliefern. Unicode wird ständig um Zeichen weiterer Schriftsysteme ergänzt. 1991 wurde nach mehrjähriger Entwicklungszeit die Version 1.0.0 des Unicode-Standards veröffentlicht, die damals nur die europäischen, nahöstlichen und indischen Schriften kodierte, alles in allem ein paar hundert Zeichen. Die neueste Version ist 6.0.0, veröffentlicht im Oktober 2010 und Basis für die über 100.000 in diesem Buch vorgestellten Zeichen.

Die Autoren des Nachschlagewerks sind der Mainzer Professor Johannes Bergerhausen, dessen Unicode-Poster in vielen Typografie-Büros hängt (auch im FontShop, siehe Abbildung ganz unten), die Düsseldorfer Designerin Siri Poarangan (Beide Sprecher auf der kommenden TYPO Berlin 2011) sowie der Programmierer Daniel A. Becker. Gemeinsam mit Ihrem Verlag Hermann Schmidt Mainz ist es ihnen gelungen, den abstrakten Unicode-Kosmos erlebbar zu machen. Es klingt verblüffend, aber weder Poster noch Website (decodeunicode.org) konnten dies bis zuletzt leisten. Das Buch inszeniert den Kosmos der Schriftzeichen wie eine spannende Kreuzfahrt – mit Farbigkeit, vorzüglicher Navigation, verschiedenen Papiersorten, Zwischenseiten, Essays und Anhängen. Es gliedert sich in die vier Kapitel Unicode (eine reich bebilderte Einführung), Zeichentabellen (alle 109.242 Zeichen auf rund 550 Seiten netto), Schriftsysteme (inklusive aller 111 noch nicht im Unicode aufgenommenen Schriftsysteme) und Anhang.

Das Jahr ist zwar noch nicht zu Ende, aber für mich ist Decodeunicode schon jetzt so etwas wie das Buch des Jahres. Selbst wer sich nicht tagtäglich mit Sprachen und Zeichen beschäftigt bleibt sofort hängen an den liebevoll gestalteten Tabellen und Hintergrundberichten. Ich hoffe, dass die oben abgebildete Leseprobe aus Issuu etwas von dem Zauber vermittelt.

Decodeunicode wird in einem geprägten Festeinband geliefert (wunderbar »ledrig« anzufassen) und kostet angemessene 68,– €. FontShop hat es sich schon aufs Lager gelegt, hier geht es zur Bestellung auf www.fontblog.de …

11 Kommentare

Kommentarfunktion ist deaktiviert.

<em>kursiv</em> <strong>fett</strong> <blockquote>Zitat</blockquote>

<a href="http://www…">Link</a> <img src="http://bildadresse.jpg">

Thomas Hühn

Das ist natürlich ein nettes Schmöker-Buch, aber eigentlich verzerrt es den Blick auf Unicode in zweierlei Hinsicht:

Zum einen standardisiert Unicode eben nicht nur die Codepunkte (dafür kann man ja dann auch ISO 10646 nehmen), sondern baut eine riesige Maschinerie an Normalisierungen, Transferkodierungen und tausend anderen Dingen (sogar ganze Algorithmen) drumherum.

Zum anderen fokussiert das Buch eben aus offensichtlichen Gründen (eben „offen-sichtlich“) auf die konkrete Ausgestaltung der Glyphen. Die wiederum sind explizit nicht durch die Unicode-Anstrengung erfaßt. Die Glyphen in den Tabellen sind stets nur Beispiele, ohne normativen Anspruch.

Trotzdem ein nettes Projekt.

Plamen Tanovski

A, wie ich gerade sehe, hat auch Unicode 6 keine (mit zwei alten Ausnahmen) akzentuierte kyrillische Vokale. Das ist sehr schlimm und traurig. Aber Hauptsache Fähnchen schwenken am 24. Mai … Erst neulich musste ich für ein Russisch-Lehrbuch alle betonten Vokale über kombinierte diakr. Zeichen zusammenschustern. Tja, wie war der Spruch nochmal, jede Schriftgruppe verdient ihr Unicode, oder so. Wie hat de Groot eigentlich die akz. kyr. Vokale in Corpid kodiert? Über den priv. Bereich?

Thomas Kunz

@ Thomas Hühn: Im Buch wird ausdrücklich darauf hingewiesen, dass die Glyphen »kein normativer Teil des Standards [sind]. Unicode codiert Zeichen, keine Glyphen.« Wen die Dinge interessieren, die du ansprichst, ist mit Jukka K. Korpela »Unicode – Explained« und Yannis Haralambous »Fonts & Encodings« (beide verlegt bei O’Reilly) gut beraten.

Jens Kutílek

wie ich gerade sehe, hat auch Unicode 6 keine (mit zwei alten Ausnahmen) akzentuierte kyrillische Vokale. Das ist sehr schlimm und traurig. … Erst neulich musste ich für ein Russisch-Lehrbuch alle betonten Vokale über kombinierte diakr. Zeichen zusammenschustern.

Das ist weder schlimm noch traurig, denn Unicode nimmt keine neuen Zeichen mehr auf, die durch Kombination von bereits kodierten Zeichen und die im Unicode definierten Kompositionsregeln darstellbar sind. Daß überhaupt Akzentbuchstaben kodiert sind, ist der Kompatibilität mit historischen Codepages geschuldet.

Die Benutzung von Combining Diacritics ist also kein »Zusammenschustern«, sondern der vorgesehene Weg. Wenn das nicht richtig klappt, liegt das vermutlich an mangelnder Unterstützung der Mark Positioning Features im benutzten Font oder Deines Satzprogramms.

Plamen Tanovski

O, das ist sogar noch trauriger, sollte das stimmen. Offensichtlich sind dann manche Alphabete „gleicher“ als andere. Aber ich glaube nicht, dass z.B. alle Zeichen aus „Latin Extended Additional“ in einer Kodierung früher existiert haben.

Schon mal Texte (besonders in WYSIWYG) mit kombinierten Zeichen bearbeitet? Es ist ein Kramf. Denn man muss immer aufpassen, gleich die beiden Zeichen (Vokal und Akzent) zu markieren/kopieren/löschen etc. Suchen und Ersetzen ist genauso umständlich, auch Trennprogramme versagen an solchen Stellen.

Nun, erstmal haben Qualitätsfonts verschiedene Akzente für Groß- und Kleinbuchstaben. Unicode hat dagegen im komb. Block nur eine Sorte. Zweitens, auch wenn ich kein Schriftentwerfer bin, könnte ich mir vorstellen, dass Gravis und Akut unterschiedlich platziert werden müssen. Trotzdem vielen Dank für den Hinweis, dieses Feature kannte ich nicht. Welche Schriften haben überhaupt kyr. Vokale mit diesen Angaben? Ich habe jetzt PTSans und Calibri mit ttx nach XML konvertiert und nach „mark“ oder „mkmk“ gesucht, aber nichts gefunden.

Ralf Herrmann

Schon, aber das sind ja die Unzulänglichkeiten aktueller Satzprogramme. Da kann ja Unicode nix dafür. Letzteres »denkt« in viel größeren Dimensionen und es wäre schlimm, wenn man sich dabei den Unzulänglichkeiten der Programme von 2011 beugen würde.

Plamen Tanovski

Andersrum gefragt: welche andere moderne Alphabete, die von zig Millionen Menschen geschrieben werden, sind nach Unicode gezwungen, Zeichen zu kombinieren?! Selbst das polytonische Altgriechisch, das von niemandem mehr geschireben wird (außer für wiss. Zwecke natürlich), tropft nur so von akzentuierten Vokalen.

Aber wie gesagt, das Traurige ist eben, dass keiner aus dem kyr. Raum bei Unicode die Aufnahme dieser Zeichen bis jetzt beantragt hat. Zumindest habe ich nichts gefunden.

Jens Kutílek

Nun, erstmal haben Qualitätsfonts verschiedene Akzente für Groß- und Kleinbuchstaben. Unicode hat dagegen im komb. Block nur eine Sorte.

Weil, wie schon geschrieben, Unicode Zeichen kodiert und keine Glyphen. Den Austausch der Akzente durch passendere Formen kann der Entwerfer auf der Font-Ebene per OpenType-Layout programmieren, davon muß die Zeichencodierungs-Ebene nichts wissen.

Zweitens, auch wenn ich kein Schriftentwerfer bin, könnte ich mir vorstellen, dass Gravis und Akut unterschiedlich platziert werden müssen.

Auch das ist möglich und nur durch den Fleiß des Entwerfers beschränkt ;) Die Angaben fürs Mark Positioning lassen sich beliebig fein differenzieren.

Ich habe jetzt PTSans und Calibri mit ttx nach XML konvertiert und nach “mark” oder “mkmk” gesucht, aber nichts gefunden.

In der bei Windows 7 mitgelieferten Calibri sind diese Features drin, in der GPOS-Tabelle solltest Du die Feature-Tags mark und mkmk finden können.

Dan Reynolds

Es kommt wahrscheinlich viel häufiger vor, als du denkst. Zum Beispiel bei allen indischen Schreibsystemen ist es der Fall.

Robin Scholz

Das Buch! Hier geht es um das Buuuuuuuch!

reparatii pc bucuresti

Generally I don’t learn article on blogs, however I would like to

say that this write-up very compelled me to take a look at and do so!

Your writing taste has been surprised me.

Thank you, quite nice article.